Step Function

- 경계에서 불연속인 함수, 경계를 기준으로 결과값이 0 또는 1. >> 미분 불가

- 스위치처럼 On 이거나, Off 이거나.

Sigmoid Function

- 비선형 함수

- 0과 1사이의 값. 즉, 최댓값은 1, 최솟값은 0.

- Step function에서 부드러워진 형태

- Exploding Gradient 문제 방지

- 로지스틱 회귀분석에 사용.

>> Gradient Vanishing 문제 발생

* Gradient Vanishing

: 출력값이 0에 매우 가까워짐. Back-propagation 할 때, layer 많이 통과하면 결국 0으로 수렴.

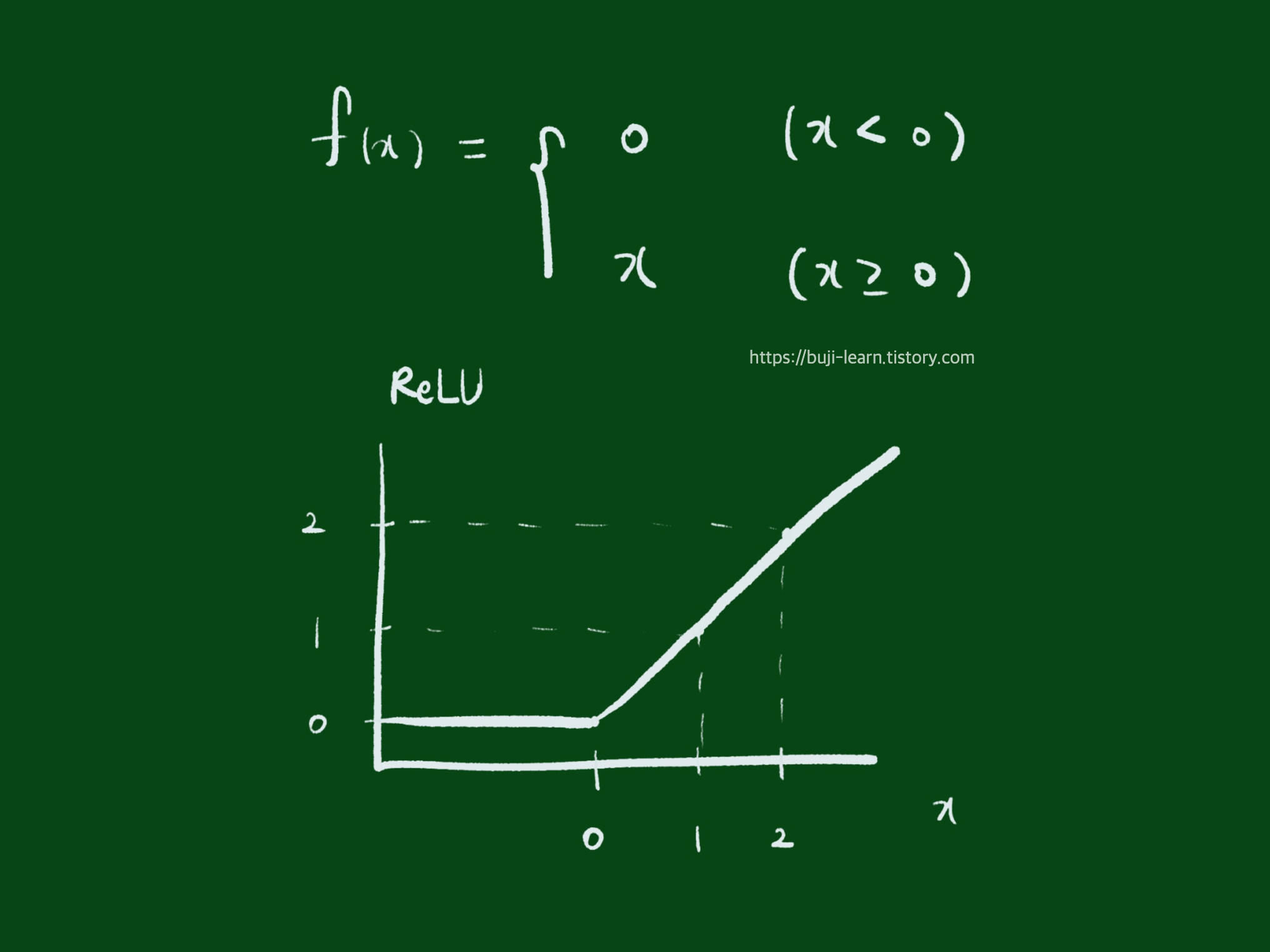

ReLU (Rectified Linear Unit) Function

- 선형함수

- Gradient Vanishing 문제 해결 목적으로 사용.

- Deep Learning에 많이 사용.

Reference

- 임호진, 송지섭, 임준혁 공저, 2022, <이기적 ADsP 데이터분석 준전문가>, 영진닷컴

'Input > AD(s)P 빅데이터(준)전문가' 카테고리의 다른 글

| 비지도학습(자율학습) 연관규칙 : 지지도, 신뢰도, 향상도 계산식 / 장단점 (0) | 2023.05.18 |

|---|---|

| 유사성 판단을 위한 거리 척도 : 유클라디안 거리, 민코프스키 거리, 마할라노비스 거리, 맨하튼 거리 (0) | 2023.05.18 |